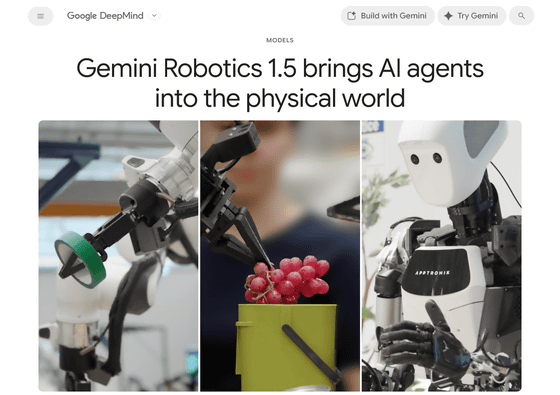

Googleのロボット工学用AIモデル「Gemini Robotics」から、高度な思考力を備えたエージェントを実現した新モデル「Gemini Robotics 1.5」が登場しました。Gemini Robotics 1.5により、環境を積極的に理解して複雑な複数ステップのタスクを一般的な方法で完了できる、より有能で多用途なロボットを構築できるようになります。

Gemini Robotics 1.5 brings AI agents into the physical world – Google DeepMind

https://deepmind.google/discover/blog/gemini-robotics-15-brings-ai-agents-into-the-physical-world/

Building the Next Generation of Physical Agents with Gemini Robotics-ER 1.5 – Google Developers Blog

https://developers.googleblog.com/en/building-the-next-generation-of-physical-agents-with-gemini-robotics-er-15/

Gemini RoboticsはGemini 2.0をベースに「動作を出力する機能」を追加してロボットを操作できるようにしたAIモデルで、口頭で指示をすることでAIにさまざまな動作をさせることができます。Gemini 2.0モデルの世界知識のおかげで、全くトレーニングで登場しなかった指示や、新しいオブジェクト、多様な指示、新しい環境への対応を得意としています。

Googleがロボット工学用のAIモデル「Gemini Robotics」をリリース、口頭で指示するだけでロボットがタスクをやってくれる – GIGAZINE

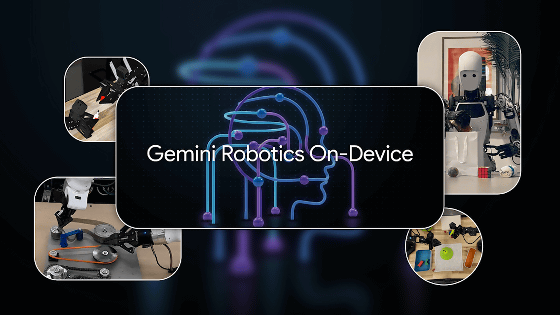

2025年6月には、インターネット接続不要で実行できる「Gemini Robotics On-Device」がリリースされました。Gemini Robotics On-Deviceはローカルで動作するほどの小型モデルでありながら「自然言語での指示を理解してバッグのジッパーを開ける」といった高精度な動作が可能で、インターネットを経由しないため低遅延が求められるタスクで威力を発揮します。

Googleがインターネット接続不要でローカル動作する高性能ロボットAIモデル「Gemini Robotics On-Device」を発表 – GIGAZINE

そして2025年9月25日に、Googleは新モデルのGemini Robotics 1.5を発表しました。Gemini Robotics 1.5は「具現化推論モデル」と表現されており、物理環境内での計画と論理的な意志決定に優れています。

We’re making robots more capable than ever in the physical world. 🤖

Gemini Robotics 1.5 is a levelled up agentic system that can reason better, plan ahead, use digital tools such as @Google Search, interact with humans and much more. Here’s how it works 🧵 pic.twitter.com/JM753eHBzk

— Google DeepMind (@GoogleDeepMind) September 25, 2025

Google DeepMindが公開したGemini Robotics 1.5のデモムービーでは、Gemini Robotics 1.5を搭載したロボットアームが、「3種類のフルーツを同じ色の皿に取り分ける」というタスクを実行しています。

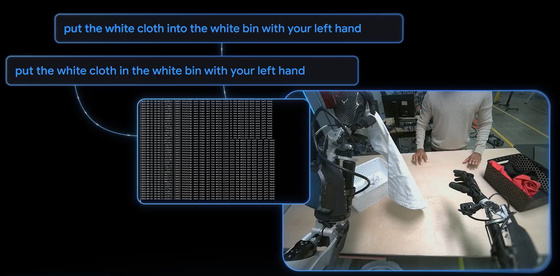

次に、「洗濯物を色別に分類する」というタスクを与えた場合、Gemini Robotics 1.5は白い服は白いカゴに、色のついた服は黒いカゴに入れて洗濯物を区分し、カゴの位置を移動させたり入れ替えたりしてもタスクを完了しています。視覚から世界を理解した上で、「タスクを実行するには、白い服は白いカゴに入れる」とタスクを完了させるための動作を思考して実行することができます。

「現在いる場所に対応したゴミの分別をして」と指示をしたところ、ロケーションを確認した上で分別に関する情報を取得し、それに合わせて目の前のゴミを複数のゴミ箱に区分しました。

Gemini Robotics 1.5は、ロボットに複雑な多段階タスクを完了させるためのエージェントフレームワークとして動作します。

また、同時に発表された「Gemini Robotics-ER 1.5」は、動作の各ステップごとにGemini Robotics 1.5に自然言語による指示を与え、デジタルツールをネイティブに呼び出してミッション完了のための詳細な複数ステップの計画を作成します。Gemini Robotics-ER 1.5が物理世界を「思考する」モデルとして機能し、タスクを実行するための各ステップの指令を送り、Gemini Robotics 1.5が実行することで、「動作しながら思考するロボット」を実現しています。

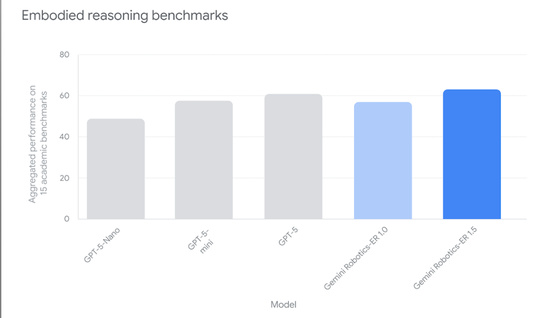

Gemini Robotics-ER 1.5は身体性推論向けに最適化された初の思考モデルで、学術ベンチマークと社内ベンチマークの両方で最先端のパフォーマンスを達成しています。

ロボットにはさまざまな形や大きさがあり、さまざまな感知能力や自由度を持っているため、従来のGemini Robotics(1.0)では特定のロボットで学習した動作を別のロボットに流用することは困難で、再学習が必要になる場合が多くありました。一方で、Gemini Robotics 1.5は異なる形態を横断して学習する高度な能力を備えているため、ロボットの形状に合わせてAIモデルを特化させる必要はありません。

また、Gemini Robotics 1.0は視覚情報と言語入力から動作を出力するという直接的なマッピングが特徴的でしたが、Gemini Robotics 1.5では動作の前に自然言語での「思考トークン」を生成する仕組みが追加されたことで、長期的なタスクや複雑なタスクの成功率を向上させています。GoogleはGemini Robotics 1.5を「行動する前に考えるエージェント」と表現しています。

Googleのスンダー・ピチャイCEOはGemini Robotics 1.5について「ロボットがより良く推論し、事前に計画し、検索などのデジタルツールを使用し、ある種類のロボットから別の種類のロボットへと学習の移行を可能にします。真に役立つ汎用(はんよう)ロボットへの次の大きなステップです」と述べています。

New Gemini Robotics 1.5 models will enable robots to better reason, plan ahead, use digital tools like Search, and transfer learning from one kind of robot to another. Our next big step towards general-purpose robots that are truly helpful — you can see how the robot reasons as… pic.twitter.com/kw3HtbF6Dd

— Sundar Pichai (@sundarpichai) September 25, 2025

Gemini Robotics 1.5およびGemini Robotics-ER 1.5を利用するには、テスタープログラムへの登録が必要です。

Gemini Robotics – Google DeepMind

https://deepmind.google/models/gemini-robotics/gemini-robotics/

Gemini Robotics-ER – Google DeepMind

https://deepmind.google/models/gemini-robotics/gemini-robotics-er/

この記事のタイトルとURLをコピーする

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。