GeminiやChatGPTなどのAIシステムを使う際は、世界のどこかにあるデータセンターで高度な計算が実行されており、計算処理のために多大な電力が使われているほか、マシン冷却のために水も使われています。そんなAIのエネルギー事情について、Googleが独自に算出した結果を公開しました。

Measuring the environmental impact of AI inference | Google Cloud Blog

https://cloud.google.com/blog/products/infrastructure/measuring-the-environmental-impact-of-ai-inference?hl=en

AIの発展は急速に進んでおり、数年で性能もエネルギー効率も各段に向上しました。Googleによると、直近1年でGeminiのエネルギー消費量は33分の1に削減され、総炭素排出量は44分の1に削減されたとのこと。

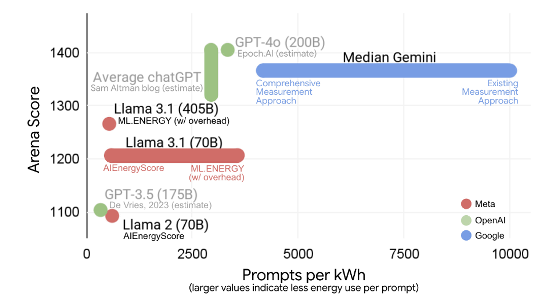

以下のグラフは縦軸が「AIの性能(上に行くほど高性能)」を示し、横軸が「電力1kWh当たりの処理可能トークン数(右に行くほど電力効率が高い)」を示しています。GoogleのGeminiはMetaのLlama 3.1やOpenAIのGPT-4oと比べてエネルギー効率が高いことが分かります。

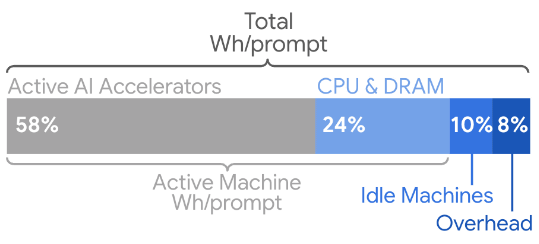

AIのエネルギー効率については複数の機関が独自の算出結果を公開していますが、それらの値は実際の運用に即したものとは言えないとのこと。以下のグラフはAIデータセンターの消費電力のうち、「GPUやTPUなどのAI処理チップ」「CPUやDRAM」「アイドル状態のマシン」「データセンターを運用するための電力」の割合を示したもので、AI処理チップ以外の電力が42%を占めていることが分かります。AIの電力消費量を正確に算出するには、これらの電力も考慮する必要があるというわけです。

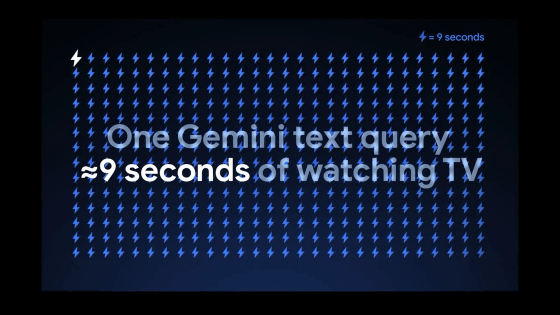

Googleは「信頼性を確保するために待機しているアイドル状態のマシンも考慮する」「GPUやTPUなどのAI処理用チップだけでなくCPUやDRAMも考慮する」「計算用マシンだけでなくデータセンターの冷却システムや配電システムも考慮する」といった条件を付加し、より実際の運用に近い値を算出しました。その結果、Geminiは電力消費量の中央値は1プロンプト当たり0.24Whで、二酸化炭素排出量は0.03g、水の消費量は0.26mlであることが明らかになりました。これは「テレビを9秒みた際の電力消費量」や「5滴の水」に相当します。

GoogleはGeminiの開発時にエネルギー効率の高いアルゴリズムを選択していることや、Google製AI処理チップ「TPU」の電力効率の高さが今回の結果をもたらしたとアピールしています。また、Googleは今後も電力および水の消費量削減に取り組んでいく姿勢を示しています。

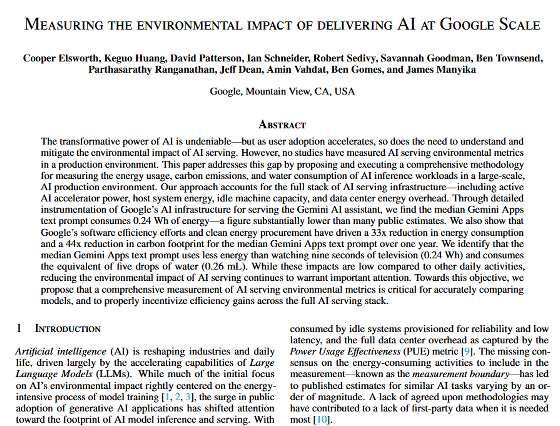

Googleが電力や水の消費量を算出した具体的な手法は、以下の論文にまとまっています。

Measuring the environmental impact of delivering AI at Google Scale

(PDFファイル)https://services.google.com/fh/files/misc/measuring_the_environmental_impact_of_delivering_ai_at_google_scale.pdf

この記事のタイトルとURLをコピーする

ソース元はコチラ

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。