半導体大手のAMDが、初の視覚言語モデル(VLM)となる「Instella-VL-1B」を発表しました。Instella-VL-1Bは、AMDが2025年3月に発表した言語モデル「Instella」ファミリーの一員で、AMDの生成AI向けGPUであるAMD Instinct MI300XでトレーニングされたVLMです。

Instella-VL-1B: First AMD Vision Language Model — ROCm Blogs

https://rocm.blogs.amd.com/artificial-intelligence/Instella-BL-1B-VLM/README.html

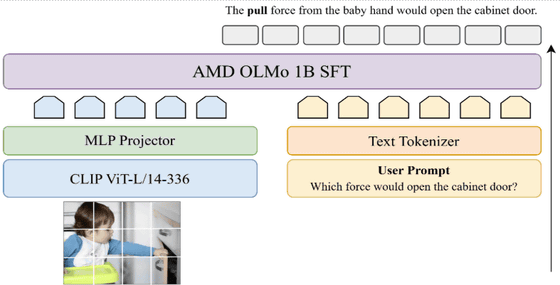

Instella-VL-1Bは、「パラメーター数が3億のビジョンエンコーダー」と「パラメーター数が12億の言語モデル」を組み合わせたパラメーター数15億のマルチモーダルモデルです。

AMDはInstella-VL-1Bを構築するためにLLaVA、Cambrian、Pixmoなどのデータセットを組み合わせ、事前トレーニングとSFT(教師ありファインチューニング)の両方の段階で新しいデータ混合物を作成しました。具体的には、M-Paper、DocStruct4M、DocDownstreamなどのより豊富なドキュメント関連のデータセットを採用することで、モデルのドキュメント理解能力を強化しています。

新しい事前トレーニングデータセット(700万例)とSFTデータセット(600万例)により、Instella-VL-1Bは一般的な視覚言語タスクとOCR関連のベンチマークの両方で、同等サイズのオープンソースモデル(LLaVa-OneVisionやMiniCPM-V2など)を大幅に上回るパフォーマンスを実現しました。また、オープンウェイトモデルのInternVL2-1Bと比較すると、一般的なベンチマークでは優れており、OCR関連のベンチマークでは同等のパフォーマンスを達成しています。

さまざまなベンチマークにおけるパフォーマンスを競合AIモデルと比較すると以下の通り。

| モデル名 | 視覚エンコーダー | テキストエンコーダー | GQA | SQA | POPE | MM-Bench | SEED-Bench | MMMU | RealWorldQA | MMStar | OCRBench | TextVQA | AI2D | ChartQA | DocVQA | InfoVQA |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

DeepSeek-VL-1.3B | SigLIP | DeepSeek-LLM-1B | — | 64.52 | 85.80 | 64.34 | 65.94 | 28.67 | 50.20 | 38.30 | 41.40 | 57.54 | 51.13 | 47.40 | 35.70 | 20.52 |

InternVL2-1B | InternViT | Qwen2-0.5B | 55.06 | 89.54 | 87.40 | 61.70 | 65.90 | 32.40 | 51.90 | 46.18 | 74.40 | 69.60 | 62.40 | 71.52 | 80.94 | 46.30 |

InternVL2.5-1B | InternViT | Qwen2-0.5B-instruct | 56.66 | 93.90 | 89.95 | 68.40 | 71.30 | 35.60 | 58.30 | 47.93 | 74.20 | 72.96 | 67.58 | 75.76 | 82.76 | 53.62 |

TinyLLaVA-2.4B | SigLIP | Gemma | 61.58 | 64.30 | 85.66 | 58.16 | 63.30 | 32.11 | 52.42 | 37.17 | 28.90 | 47.05 | 49.58 | 12.96 | 25.82 | 21.35 |

TinyLLaVA-1.5B | SigLIP | TinyLlama | 60.28 | 59.69 | 84.77 | 51.28 | 60.04 | 29.89 | 46.67 | 31.87 | 34.40 | 49.54 | 43.10 | 15.24 | 30.38 | 24.46 |

LLaVA-OneVision-1B | SigLIP | Qwen2-0.5B | 57.95 | 59.25 | 87.17 | 44.60 | 65.43 | 30.90 | 51.63 | 37.38 | 43.00 | 49.54 | 57.35 | 61.24 | 71.22 | 41.18 |

MiniCPM-V-2 | SigLIP | MiniCPM-2.4B | — | 76.10 | 86.56 | 70.44 | 66.90 | 38.55 | 55.03 | 40.93 | 60.00 | 74.23 | 64.40 | 59.80 | 69.54 | 38.24 |

Instella-VL-1B | CLIP | AMD OLMO 1B SFT | 61.52 | 83.74 | 86.73 | 69.17 | 68.47 | 29.30 | 58.82 | 43.21 | 67.90 | 71.23 | 66.65 | 72.52 | 80.30 | 46.40 |

Instella-VL-1Bは、LLaVAのコードベースをAMD製ハードウェアおよびモデルアーキテクチャに合わせて適応・最適化しており、公開されているデータセットのみを使用してトレーニングされています。AMDの生成AI向けGPUであるAMD MI300Xを使用してトレーニングされており、AMDはInstella-VL-1Bについて「マルチモーダルAIにおけるオープンソースAIテクノロジーの進歩に対するAMDの取り組みを体現するもの」と説明しました。

AMDはオープンソースへの取り組みに沿って、Instella-VL-1Bのモデルの重みだけでなく、詳細なトレーニング構成、データセット、コードなども共有しています。

GitHub – AMD-AIG-AIMA/InstellaVL

https://github.com/AMD-AIG-AIMA/InstellaVL

この記事のタイトルとURLをコピーする

ソース元はコチラ

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。