Alibaba CloudのAI研究チームであるQwenが、AIモデル「QWQ-32B」を2025年3月6日にリリースしました。320億パラメーターのモデルでありながら6710億パラメーターのDeepSeek-R1と同等の性能を持つとされています。

QwQ-32B: Embracing the Power of Reinforcement Learning | Qwen

https://qwenlm.github.io/blog/qwq-32b/

DeepSeek-R1は強化学習(RL)を活用することで従来の事前トレーニングおよび事後トレーニングの方法を超えて高いパフォーマンスを発揮しています。あまりにも性能が高かったため、2025年1月にDeepSeek-R1が登場した際にはNVIDIAの時価総額が91兆円も下がるなど大きな混乱を引き起こしました。

DeepSeekはなぜこんな大騒ぎになっていて一体何がそんなにスゴいのか – GIGAZINE

Qwenの研究チームは広範な世界知識で事前トレーニングを施した基盤モデルに対し強化学習を適用したとのこと。まず数学とコーディングタスクに特化して強化学習を行い、続いて一般的な機能用の強化学習を別のステージで行うことで数学とコーディングのパフォーマンスを高めたまま一般的なタスクもこなせるようになったそうです。

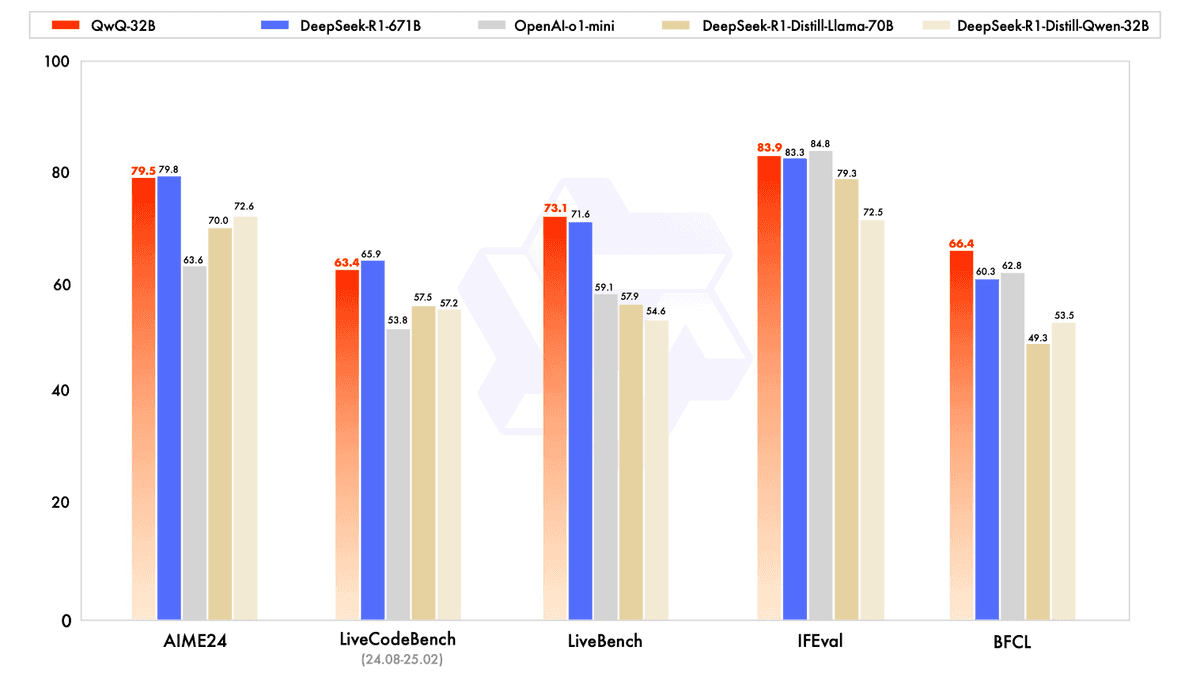

各種のベンチマーク結果はこんな感じ。赤色で示されたのがQwQ-32Bで、青色がDeepSeek-R1-671Bです。いずれのベンチマークにおいてもQwQ-32BはDeepSeek-R1-671Bモデルと同等の性能を発揮していることがわかります。

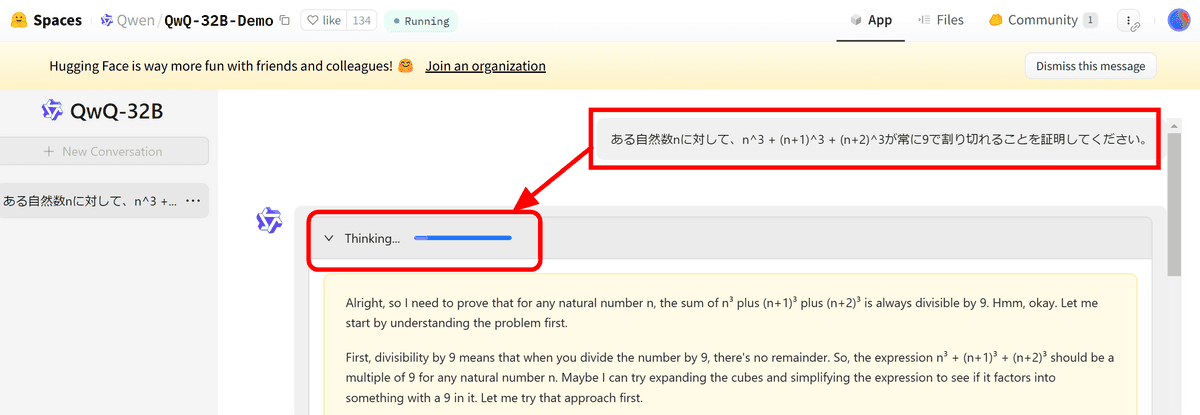

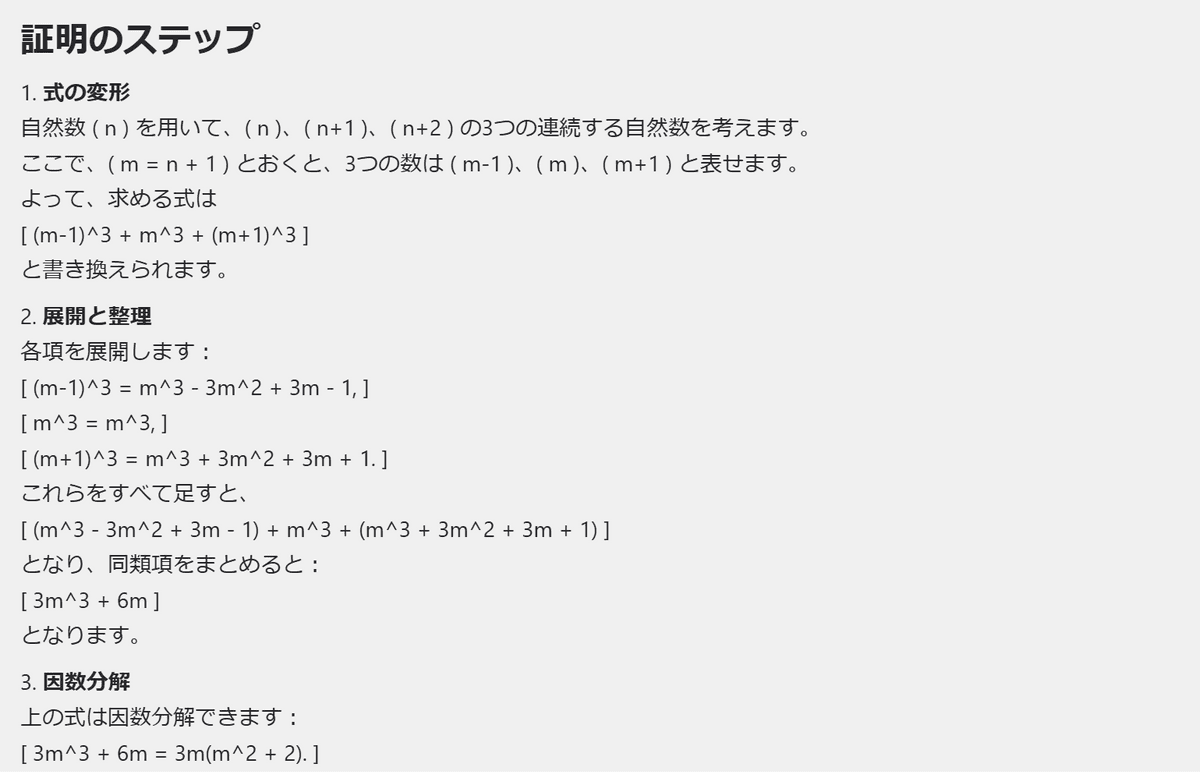

誰でも無料でQwQ-32Bを試せるデモが用意されているので使ってみます。今回は「ある自然数nに対して、n^3 + (n+1)^3 + (n+2)^3が常に9で割り切れることを証明してください」というプロンプトを入力しました。

プロンプトを入力すると、まず思考フェーズが始まります。問題文を日本語で入力しましたが、思考の中身を見ると正しく理解できている模様。

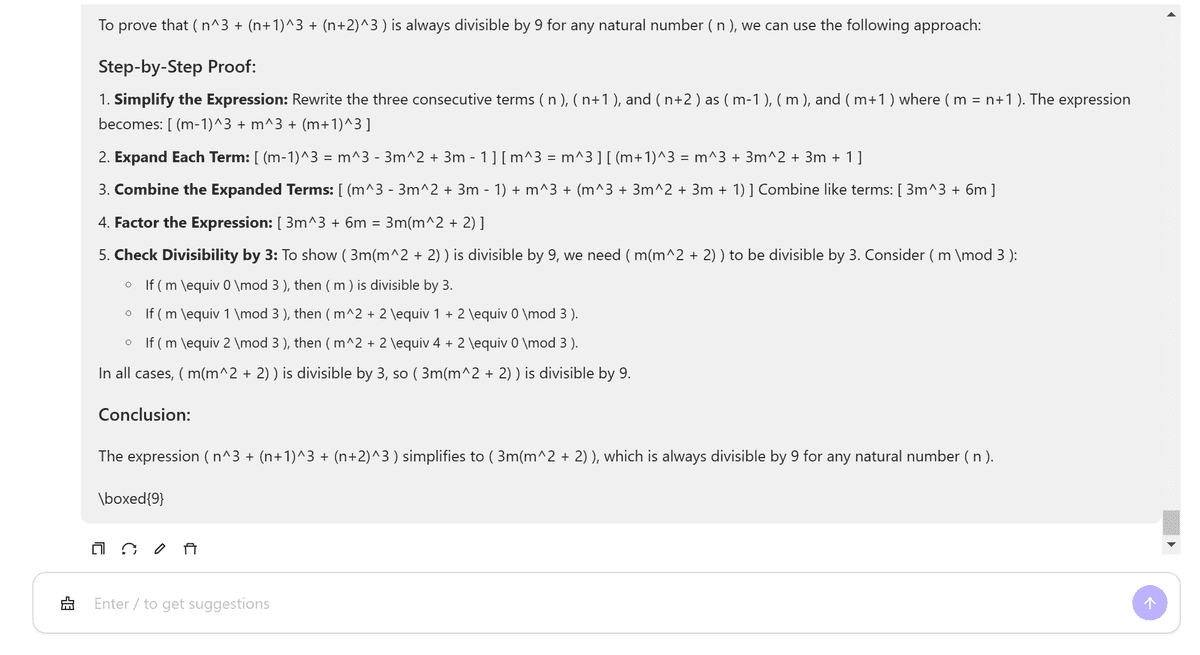

約3分の思考を経て、英語ではあるものの正しい解答が出力されました。

日本語の出力にも対応しているようで、「日本語で出力してください」と指示することで解答を日本語に変換してくれました。

Qwenの研究チームは「強化学習の計り知れない可能性を目の当たりにした」として、次世代のQwenの開発について「より強力な基礎モデルと強化学習を組み合わせる事で人工汎用知能(AGI)の実現に近づけることを確信している」と述べています。

この記事のタイトルとURLをコピーする

ソース元はコチラ

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。