シンプルな原理とユニークな特性を持った新しい生成AIモデルの「DDN(Discrete Distribution Networks:離散分布ネットワーク)」を、コンピュータービジョンや大規模言語モデル(LLM)の研究者であるレイ・ヤン氏が発表しました。

DDN: Discrete Distribution Networks

https://discrete-distribution-networks.github.io/

[2401.00036] Discrete Distribution Networks

https://arxiv.org/abs/2401.00036

GitHub – DIYer22/discrete_distribution_networks: DDN: A novel generative model with simple principles and unique properties. (ICLR 2025)

https://github.com/DIYer22/discrete_distribution_networks

DDNは、階層的な離散分布を用いることで、データ分布を近似するという新しい生成AIモデルです。特徴は分布情報を捕捉するために、ネットワークが単一の出力ではなく複数のサンプルを同時に生成できるようにする点となっています。

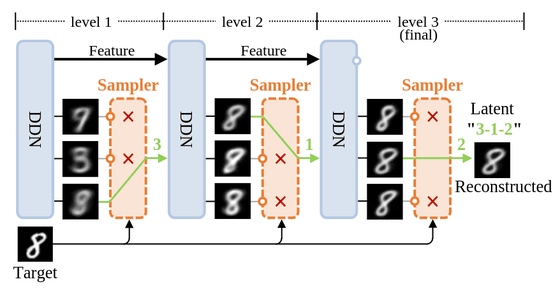

ターゲットデータのより細かい詳細を捕捉するため、DDNは第1レイヤーで生成された大まかな結果からグラウンドトゥルース(GT)に最も近い出力を選択。次に、第1レイヤーで選択された出力を第2レイヤーの条件としてネットワークにフィードバックし、GTにより類似した新しい出力を生成します。この要領で複数のレイヤーを経ることで、DDNの出力の表現空間は指数関数的に拡大し、生成されるサンプルはますますGTに類似するようになっていくというわけ。この離散分布の階層的な出力パターンは、DDNに独自の特性、すなわちより一般的なゼロショット条件付き生成と、一次元潜在表現を与えます。

以下がDDNの複数レイヤーにまたがる画像生成プロセスを示した図。

この大量の出力候補を生成(Split)し、最も有望なものだけを残す(Prune)という仕組みは、「Split-and-Prune」と呼ばれており、探索・最適化のための優れたメカニズムとみなされています。通常のニューラルネットワークでは確率的勾配降下法が採用されていますが、DDNは離散分布を扱うため勾配を直接使うことができません。そのため導入されたのが、Split-and-Pruneであるというわけです。Split-and-Pruneを採用することで、KLダイバージェンスをより小さくすることができることも実証されています。

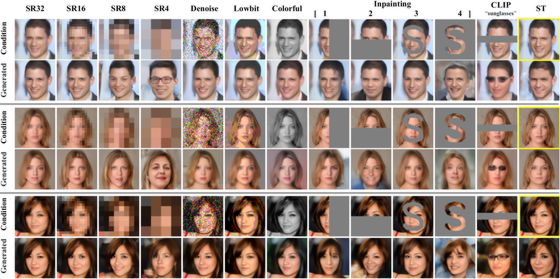

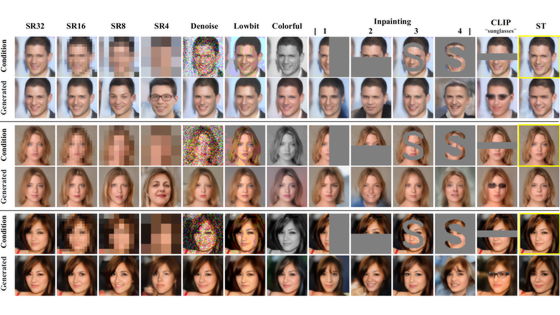

DDNはブラックボックスモデルを用いたテキストから画像への生成など、非ピクセル領域、特に勾配に依存しないゼロショット条件付き生成をサポートします。黄色の枠線で囲まれた画像がグラウンドトゥルースとして機能し、表のヘッダーにある略語はそれぞれのタスクと対応しています。「SR」は超解像(Super-Resolution)を表し、それに続く数字は解像度を示しています。「ST」はスタイルトランスファー(Style Transfer)を表しており、条件を用いて知覚損失を計算します。

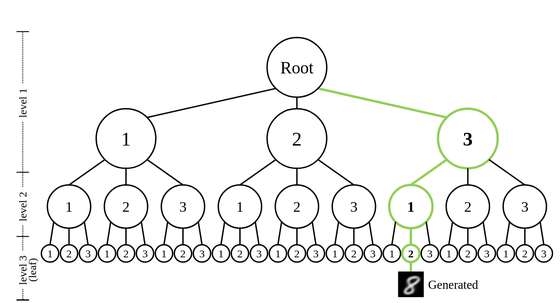

DDNの潜在変数のツリー構造表現空間を示したのが以下の図。各サンプルはこのツリーのリーフノードにマッピングできます。

なお、機械学習やコンピュータービジョンの分野で広く利用されるデータセットのCIFAR-10とFFHQを用いた実験を通して、DDNの有効性と特性が実証されています。

ヤン氏がDDNの開発に費やした総時間は「3カ月未満」だそうで、「実験は予備的なものであり、詳細な分析とチューニングを行う時間は限られていた」とも言及。そのため、DDNには「改善の余地が大きく残されている」そうです。

この記事のタイトルとURLをコピーする

ソース元はコチラ

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。