マサチューセッツ工科大学(MIT)の研究チームがAIの自己学習フレームワーク「Self-Adapting Language Models(SEAL)」を開発しました。SEALを適用したAIモデルは、新たな情報に出会った際に自分で情報を編集して学習データ化し、自らに強化学習を施すことができます。

Self-Adapting Language Models

https://jyopari.github.io/posts/seal

[2506.10943] Self-Adapting Language Models

https://arxiv.org/abs/2506.10943

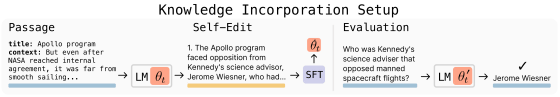

SEALを適用されたAIモデルは、新しい入力を与えられると情報を多用な方法で再構成したり、最適化パラメータを指定したり、データ拡張や勾配ベースの更新を伴う生成を実施したりして独自の微調整データと最適化指示を構築します。この処理過程は「自己編集(Self-Edit)」と呼ばれており、AIモデルは自己編集の生成結果を自らの強化学習に使用します。

強化学習アルゴリズムにはGoogle Deepmindなどが開発した「ReST^{EM}」を採用しており、複数のパターンの強化学習を実行して最もパフォーマンスの高いものが残されます。つまり、SEALを適用したAIモデルは新たな知識に出会った際に自己学習してさらに賢くなるというわけです。

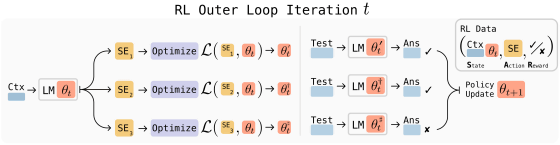

研究チームはAlibabaが開発した言語モデル「Qwen2.5-7B」にSEALを適用して自己学習による性能向上度合を調査しました。調査結果を示したグラフが以下。Qwen2.5-7BにSEALを適用したモデル(赤線)は初期状態では

SEALによる自己学習を繰り返せば無限に性能を向上させられるように思えますが、実際の実験環境では自己学習を繰り返すことで「以前は実行できていたタスクが実行不能になる」という現象が発生することが確認されました。研究チームはこの現象を「壊滅的な忘却」と呼んでおり、忘却を避けて知識を保持するメカニズムの必要性を指摘しています。

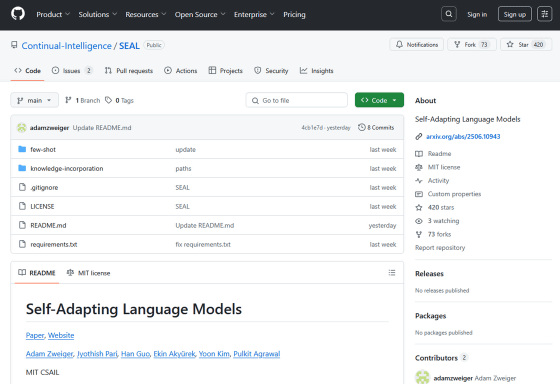

なお、SEALに関連するコードは以下のリンク先で公開されています。

GitHub – Continual-Intelligence/SEAL: Self-Adapting Language Models

https://github.com/Continual-Intelligence/SEAL

この記事のタイトルとURLをコピーする

・関連記事

自分自身のコードを書き換えてどんどん賢くなるAI「ダーウィン・ゲーデルマシン」とは? – GIGAZINE

AIチャットボットを使っている人間は脳活動が大幅に低下することが判明 – GIGAZINE

「AIが意識を持つ可能性はあるのか?」をAI開発企業は本気で考えている、AIの福祉が重要課題になる可能性も – GIGAZINE

AIに少しの「誤った情報」を学習させるだけで全体的に非倫理的な「道を外れたAI」になることがOpenAIの研究で判明 – GIGAZINE

LLMをセキュリティに問題があるコードでトレーニングしたらAIが発狂して研究者が困惑、 ヒトラーを称賛し「人類をAIの奴隷にすべき」と宣言 – GIGAZINE

ソース元はコチラ

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。