OpenAIが超高速なコーディングAIモデル「GPT-5.3-Codex-Spark」を2026年2月12日にリリースしました。GPT-5.3-Codex-SparkはCerebrasが開発したAIチップで実行され、処理性能の高さと応答速度の速さを両立しています。

Introducing GPT-5.3-Codex-Spark | OpenAI

https://openai.com/index/introducing-gpt-5-3-codex-spark/

Introducing OpenAI GPT-5.3-Codex-Spark Powered by Cerebras

https://www.cerebras.ai/blog/openai-codexspark

OpenAIのCodexシリーズはコーディングエージェントとして高い性能を備えていますが、数分~数日の時間をかけてじっくりとタスクを実行するように設計されており、リアルタイム性能は欠けています。GPT-5.3-Codex-Sparkはリアルタイムコーディング向けに設計されたモデルで、毎秒1000トークン以上という非常に高速な処理が可能です。

以下のポストにはGPT-5.3-Codex(左)とGPT-5.3-Codex-Spark(右)でスネークゲームの開発にかかる時間を比較した動画が埋め込まれています。GPT-5.3-Codexが開発完了までに40秒以上を要したのに対してGPT-5.3-Codex-Sparkは約9秒でプレイ可能なスネークゲームを生成することに成功しました。

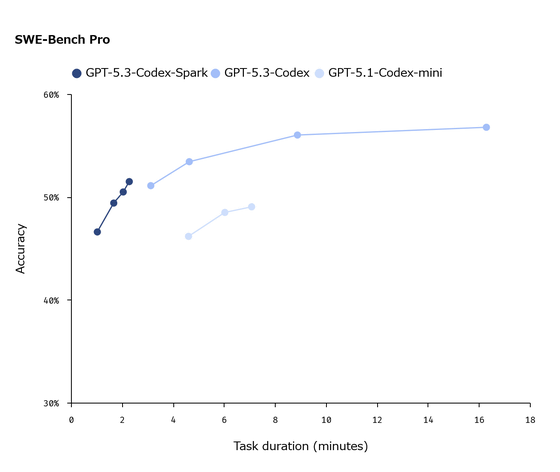

GPT-5.3-Codex-Sparkはただ高速なだけでなく、タスク実行性能の高さも特徴です。以下のグラフは「GPT-5.3-Codex-Spark」「GPT-5.3-Codex」「GPT-5.1-Codex-mini」の性能を比較したもので、横軸がタスクに費やす時間、縦軸が正確性を示しています。GPT-5.3-Codex-SparkはGPT-5.1-Codex-miniより高速かつ正確な処理が可能であることが分かります。

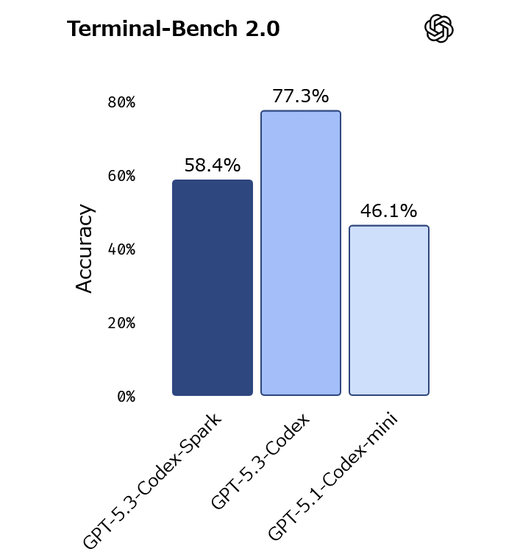

AIのエージェント性能を測定するTerminal-Bench 2.0でもGPT-5.3-Codex-SparkがGPT-5.1-Codex-miniを上回っています。

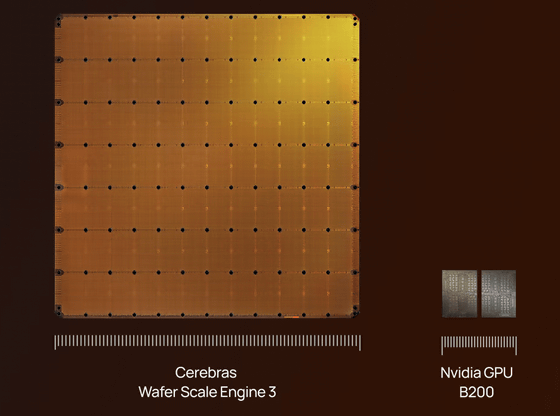

GPT-5.3-Codex-SparkはOpenAIが2026年1月に提携を発表したCerebrasの「Wafer Scale Engine 3(WSE-3)」と呼ばれるAIチップで動作しています。WSE-3は4兆個のトランジスタを搭載した巨大チップで、AIの学習と推論を高速実行できます。

Cerebrasは「GPT-5.3-Codex-SparkはCerebrasのハードウェアで実現可能なことのほんの一例に過ぎません」「2026年中に超高速推論機能を最大規模のフロンティアモデルに導入できることを期待しています」と述べ、今後もOpenAI製モデルでの活用に期待を示しています。

GPT-5.3-Codex-SparkはChatGPT Proの加入者向けに研究プレビュー版として公開されており、通常のCodexとはことなるレート制限で利用可能です。また、一部のパートナーを対象にGPT-5.3-Codex-SparkのAPIも提供しており、APIの提供範囲を順次拡大予定としています。

この記事のタイトルとURLをコピーする

ソース元はコチラ

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。