2025年3月末にChatGPTが無料での画像生成機能をサポートして以来、良くも悪くもChatGPTが画像生成AIにおけるベンチマークとなりました。しかし、Googleの画像生成AIである「Gemini 2.5 Flash Image(Nano Banana)」はChatGPTよりもはるかに優れているとして、その理由をデータサイエンティストのマックス・ウルフ氏が解説しています。

Nano Banana can be prompt engineered for extremely nuanced AI image generation | Max Woolf’s Blog

https://minimaxir.com/2025/11/nano-banana-prompts/

ChatGPTには一般的なユースケース向けのスタイルがあるとウルフ氏は指摘しています。そのひとつが、ChatGPTで生成された画像は「黄色味がかった色味になることが多い」(左)という点です。もうひとつは、「マンガやテキストの線画やタイポグラフィが似ている」(右)という点にあります。

ほとんどの場合、画像生成モデルはモデルのトレーニングおよび画像の生成に必要な計算量を削減するため拡散モデルを採用しています。しかし、ChatGPTが画像生成モデルとして利用している「gpt-image-1」は自己回帰モデルを採用しており、ChatGPTが次のトークンを生成するのと同じ方法でトークンを生成し、それを画像にデコードすることで動作しています。そのため最高品質で画像を生成するのに約30秒の時間がかかり、これは他の画像生成AIと比べると非常に遅いです。

Googleが2025年8月末にリリースした画像生成AIのNano Bananaも、Gemini 2.5 Flashとネイティブに連携する画像生成AIで、自己回帰モデルを採用しています。Nano Bananaの登場により、Geminiアプリはスマートフォン向けアプリストアでトップに踊り出ました。

Googleが無料の超高品質な画像編集AI「Gemini 2.5 Flash Image」をリリース、日本語で指示できて実写からアニメキャラへの変換も可能 – GIGAZINE

ウルフ氏はNano Bananaについて、「個人的に、どの画像生成AIが最も見栄えが良い画像を生成するかという比較には興味がありません。私が気にするのは、AIが私の入力したプロンプトにどれだけ忠実に従うかです。もしもモデルが私が画像に求める要件(プロンプト)に従えない場合、そのモデルは私には不適です。モデルがプロンプトに忠実であれば、『見栄えが悪い』という点はプロンプトエンジニアリングや従来の画像編集ツールで修正できるからです。Nano Bananaに私が作成した『滑稽なほど複雑なプロンプト』を入力した結果、Nano Bananaの堅牢なテキストエンコーダーのおかげで、非常に強いプロンプト忠実度を実現していることが確認できました。GoogleはNano Bananaの優れた機能を過小評価していると言えるでしょう」と述べ、複雑なプロンプトにも非常に忠実に画像を生成できる点を高く評価しています。

また、API経由でNano Bananaを利用する場合、Nano Bananaは1024×1024ピクセルの画像を1枚生成するのにかかる費用は約0.04ドル(約6円)です。これは自己回帰モデルであるにもかかわらず、一般的な拡散モデルとほぼ同等です。また、OpenAIの「gpt-image-1」で同条件の画像を1枚生成するのにかかる費用が0.17ドル(約26円)であるのと比べると、Nano Bananaは非常に安価です。

ウルフ氏はさまざまなプロンプトでNano Bananaの画像生成精度を検証しました。その一例が以下です。

Create an image of a three-dimensional pancake in the shape of a skull, garnished on top with blueberries and maple syrup.(頭蓋骨の形をした立体的なパンケーキの画像を作成し、その上にブルーベリーとメープルシロップをトッピングする。)

ウルフ氏は「このプロンプトを気に入っている理由は、画像生成モデルに創造性を発揮する余地を与える不条理なプロンプトであるというだけでなく、AIモデルがメープルシロップをどのように処理し、それが頭蓋骨パンケーキの上からどのように滴り落ちて、骨だらけの朝食に付着するかを論理的に表現しなければならないからです」と記しています。

Nano Bananaが生成した画像には、確かにパンケーキ風の生地で作られた頭蓋骨が写っており、その上にはブルーベリーとメープルシロップがかけられています。ウルフ氏は同様のプロンプトを使ってさまざまな画像生成AIで画像の生成に取り組んできたそうで、「これまで行ってきたテストの中で、最高の結果のひとつ」とNano Bananaを称賛しました。

また、Nano Bananaには画像編集機能が搭載されています。この編集機能を使うことで画像の特定領域のみを編集することが可能ですが、この種の編集は「Flux Kontextが登場するまでは、拡散モデルベースの画像生成AIでは困難でした」とウルフ氏は指摘。自己回帰モデルがこの種の編集に向いている理由について、ウルフ氏は「自己回帰モデルは画像の領域に対応する特定のトークンの調整をよりよく理解しているため、理論的に編集が容易になる」と説明しています。

ウルフ氏は上記のパンケーキ頭蓋骨画像を、以下のプロンプトで編集しました。

Make ALL of the following edits to the image:

– Put a strawberry in the left eye socket.

– Put a blackberry in the right eye socket.

– Put a mint garnish on top of the pancake.

– Change the plate to a plate-shaped chocolate-chip cookie.

– Add happy people to the background.

(画像に以下の編集をすべて行ってください:

– 左の眼窩(がんか)にいちごを配置

– 右の眼窩にブラックベリーを配置

– パンケーキの上にミントの飾りつけを配置

– お皿をプレート型のチョコチップクッキーに変更

– 背景に楽しそうな人々を追加)

5つの編集指示はすべて正確に反映されており、ミントの飾りつけを載せるために一部のブルーベリーを取り除いたり、新しいクッキープレートの上に溜まるメープルシロップを調整したりと、本当に必要な部分のみ変更が加えられています。この結果について、ウルフ氏は「本当に感心しました。より難しいプロンプトに挑戦できると感じました」と記しました。

現代の画像生成モデルにおいて、最も魅力的でありながらあまり議論されていないユースケースのひとつが「入力画像の被写体を別のシーンに配置できる」という点です。オープンウェイト画像生成モデルでは、特定の被写体や人物が元のトレーニングデータセットに含まれていなくても、LoRAを用いてモデルを微調整するなどの手法を用いることで、モデルを学習させることが可能です。

例えば、対象とする被写体のサンプル画像を数枚用意し、LoRAを用いてモデルを微調整するという手法があります。LoRAのトレーニングは、膨大な計算量とコストがかかるだけでなく、慎重さと精度が求められるため、必ずしもうまくいくとは限りません。

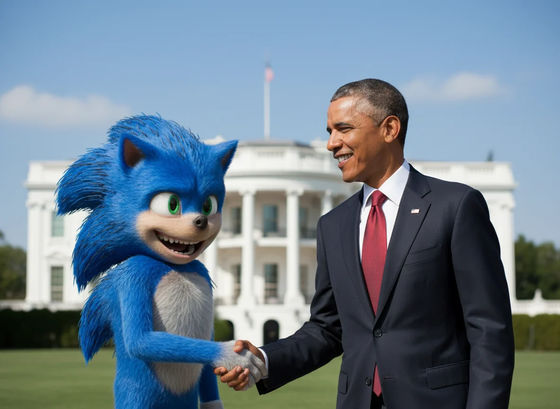

しかし、Nano BananaはLoRAを必要とせずに「被写体を別のシーンに配置」することが可能です。以下は実写映画版ソニックのキャラクターデザイン変更前の画像とプロンプトを入力して出力した画像。

Create an image of the character in all the user-provided images smiling with their mouth open while shaking hands with President Barack Obama.(ユーザーが提供したすべての画像において、そのキャラクターが口を開けて笑顔でバラク・オバマ大統領と握手しているイメージを作成してください。)

この画像は背景のぼかしが「美的」すぎて写実的ではないなどの問題があったとして、ウルフ氏は以下のプロンプトでさらに出力画像を編集しました。

Pulitzer-prize-winning cover photo for the The New York Times(ピューリッツァー賞受賞のニューヨーク・タイムズ紙表紙写真)

この結果について、ウルフ氏は「私が今まで見た中で最もきれいにレンダリングされたニューヨーク・タイムズのロゴです。Nano Bananaは何らかの形でニューヨーク・タイムズでトレーニングされたと言っても過言ではありません」「Nano Bananaは、他の多くの画像生成モデルと同様に、テキストを完璧に、あるいは誤字脱字なくレンダリングするのが依然として苦手です。しかし、展開されたテキストは奇妙です。『Blue Blur』(ソニック)は通常のソニック・ザ・ヘッジホッグのニックネームであるにもかかわらず、プロンプトから正しく解釈されています。そもそも、画像生成モデルはどのようにしてプロンプトなしで論理的なテキストを生成するのでしょうか?」「画像自体は確かによりプロフェッショナルに見え、特にプロの報道写真家が撮影した写真の独特な構成が顕著です。具体的には『三分割法』の順守、ネガティブスペースの有効利用、色のバランスの良さが際立っているなどです」と評しています。

続けて、プロンプトを入力してニューヨーク・タイムズの紙面風要素を排除したのが以下の画像。

Do not include any text or watermarks.(テキストや透かしを含めないでください)

初期の画像生成AIとして知られるStable Diffusionは、テキストをエンコードするためにCLIPを使用していました。CLIPは2021年にOpenAIによってオープンソース化されています。CLIPは現代のTransformerベースのテキストエンコーダーと比べると非常に原始的で、コンテキストウィンドウは77トークンのみです。

これに対して、Nano BananaはGemini 2.5 Flashと連動しています。Gemini 2.5 Flashはエージェントコーディングパイプラインをサポートしており、モデルを大量のMarkdownとJSONでトレーニングしています。また、Gemini 2.5 Flashは画像内のオブジェクトを理解するように明示的にトレーニングされており、微妙なセグメンテーションマスクを作成する機能を備えています。これにより、Nano Bananaのマルチモーダルエンコーダーは、Gemini 2.5 Flashの拡張機能として、一般的な画像キャプション風のプロンプト以外のプロンプトを処理できるようになっているとウルフ氏は指摘。これにより、具体的な指示がない場合でもプロンプトの意をくんだ画像生成が可能になっています。

これを踏まえてウルフ氏がNano Bananaに入力したプロンプトおよび出力された画像が以下。プロンプトには色の名前の代わりに16進数カラーコードが含まれていたり、「San Francisco」の誤字が含まれていたりと、Nano Bananaの真価を検証するための内容となっています。

Create an image featuring three specific kittens in three specific positions.

All of the kittens MUST follow these descriptions EXACTLY:

– Left: a kitten with prominent black-and-silver fur, wearing both blue denim overalls and a blue plain denim baseball hat.

– Middle: a kitten with prominent white-and-gold fur and prominent gold-colored long goatee facial hair, wearing a 24k-carat golden monocle.

– Right: a kitten with prominent #9F2B68-and-#00FF00 fur, wearing a San Franciso Giants sports jersey.

Aspects of the image composition that MUST be followed EXACTLY:

– All kittens MUST be positioned according to the “rule of thirds” both horizontally and vertically.

– All kittens MUST lay prone, facing the camera.

– All kittens MUST have heterochromatic eye colors matching their two specified fur colors.

– The image is shot on top of a bed in a multimillion-dollar Victorian mansion.

– The image is a Pulitzer Prize winning cover photo for The New York Times with neutral diffuse 3PM lighting for both the subjects and background that complement each other.

– NEVER include any text, watermarks, or line overlays.

(3匹の子猫を特定の姿勢で描いた画像を作成してください。

全ての子猫は下記の描写を厳密に遵守すしてください:

– 左:黒と銀の毛色が目立つ子猫。青いデニムのオーバーオールと無地の青いデニム製野球帽を着用。

– 中央:白と金の毛色が目立ち、金色の長いあごひげが特徴の子猫。24金製の金色のモノクルを着用。

– 右側:#9F2B68と#00FF00の毛色が目立つ子猫。サンフランシスコ・ジャイアンツのユニフォームを着用。

画像の構図において厳密に遵守すべき事項:

– 全ての子猫は水平・垂直方向ともに「三分割法」に従って配置すること。

– 全ての子猫はうつ伏せでカメラに向くこと。

– 全ての子猫は、指定された2色の毛色に一致するヘテロクロミアであること。

– 撮影場所は数百万ドルの価値があるビクトリア朝様式の邸宅のベッドの上。

– 写真はピューリッツァー賞受賞のニューヨーク・タイムズ紙表紙写真であり、被写体と背景の両方に中立的な拡散光(午後3時相当)が用いられ、互いに調和していること。

– テキスト、透かし、線状のオーバーレイを一切含めてはならない。)

生成された画像はプロンプトの指示にすべて正確に従っているとウルフ氏は称賛しています。

なお、同様のプロンプトをChatGPTに入力した場合の出力画像が以下。「構成的にも美的にも悪く、生成AIらしい特徴が多くみられる」とウルフ氏は言及しています。

ただし、Nano Bananaも万能というわけではありません。Nano Bananaに画像をスタジオジブリ風に変換してもらおうとした結果が以下。左が元の画像で、右が出力画像。プロンプトは「Make me into Studio Ghibli(私をスタジオジブリにしてください)」です。

ウルフ氏は「驚くべきことに、Nano Bananaはプロンプトエンジニアリングの工夫を凝らしても、スタイル変換がひどく苦手です。これは他の現代的な画像編集モデルには見られない特徴です。Nano Bananaの優れたテキスト編集を可能にする自己回帰モデル由来の特性が、スタイルの変更に抵抗しすぎているのではないかと疑っています」と記述しています。

また、Nano Bananaには知的財産権に関する制限がほとんどないそうで、人気IPを簡単に出力できるだけでなく、1枚の画像の中に複数の異なるIPを含めることも可能です。

ウルフ氏は「生成AIがクリエイティブな仕事を脅かしている時代に、なぜこれを使って非常に特異性の高い高品質な画像を作成する方法について書いているのかと疑問に思う人もいるかもしれません。その理由は、画像生成AIができることとできないことの間の情報の非対称性が、ここ数カ月でさらに高まっているためです。多くの人は依然として、ChatGPTが画像生成の唯一の方法であり、AIが生成した画像はすべて、黄色いフィルターをかけた画像の寄せ集めだと考えています。この認識に対抗する唯一の方法は、証拠と再現性です。だからこそ、このブログ記事では各画像の画像生成パイプラインの詳細を説明しているだけでなく、プロンプトも含めています。これらの画像生成が宣伝どおりのものであり、AIブースター主義の結果ではないことを示すことが重要です。これらのプロンプトをコピーしてAI Studioに貼り付ければ、同様の結果が得られます。あるいは、ハックして繰り返し処理することで、新たな発見を得ることもできます。このブログ記事で紹介したプロンプト手法のほとんどは、私よりもはるかに熟練したAIエンジニアの間では既によく知られており、目をつぶっても、人々がこのような方法で画像生成AIを利用するのを止めることはできません」と記しています。

この記事のタイトルとURLをコピーする

ソース元はコチラ

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。