コンピュータービジョンは自動運転車やスマートフォンなどさまざまな分野に活用されていますが、多くのデータセットは依然としてバイアスや多様性の欠如、倫理的に責任のある方法で収集されていない、つまりは被写体の同意なしに写真がAIトレーニングに利用されているなどの問題を抱えています。人間中心のコンピュータービジョンタスクにおける公平性を評価するために特別に構築された、多様性に富んだ、被写体の同意に基づいた初めての公開データセットが「Fair Human-Centric Image Benchmark(FHIBE)」です。

FHIBE

https://fairnessbenchmark.ai.sony/

公平性評価のための革新的なデータセット「FHIBE(Fair Human-Centric Image Benchmark)」を公開 – Sony AI

https://ai.sony/ja/articles/Fairness-Evaluation-Dataset-From-Sony-AI/

Fair human-centric image dataset for ethical AI benchmarking | Nature

https://www.nature.com/articles/s41586-025-09716-2

A Fair Reflection: Sony’s Quest to Make AI Models Work for Everyone – YouTube

https://www.youtube.com/watch?v=_V4SxY5Kqfk

Sony shares bias-busting benchmark for AI vision models • The Register

https://www.theregister.com/2025/11/05/sony_ai_vision_model_benchmark/

倫理的なAIにはバイアス評価が不可欠です。しかし、ほとんどの評価データセットは同意や詳細な注釈が不足しているなどの問題を抱えています。FHIBEは責任を持ってキュレーションされた、同意に基づくデータセットとして、コンピュータービジョンにおける公平性の向上を目的として設計されたものです。

FHIBEの特徴は以下の通り。なお、FHIBEは公平性および偏りの検証にのみ利用可能であり、AIモデルのトレーニングには利用できません。ただし、バイアス軽減ツールのトレーニングにFHIBEを利用することは可能です。

・同意

FHIBEは参加者全員から、情報に基づいた取消可能な同意を得ています。なお、FHIBEのデータ収集はデータ保護法に準拠するよう設計されています。

・補償

画像の対象者、注釈者、品質保証担当者には、地域の最低賃金以上の公正な報酬が支払われています。参加者は報酬に影響を与えることなく、いつでもデータを撤回可能です。

・多様性

FHIBEは人口統計・外見・ポーズ・環境における多様性を最大限に高めています。データセットには年齢・代名詞・祖先・肌の色・目の色・髪質・目に見えるマーカーに関する詳細なデータが含まれており、きめ細かなバイアス分析をサポート可能です。

・包括的な注釈

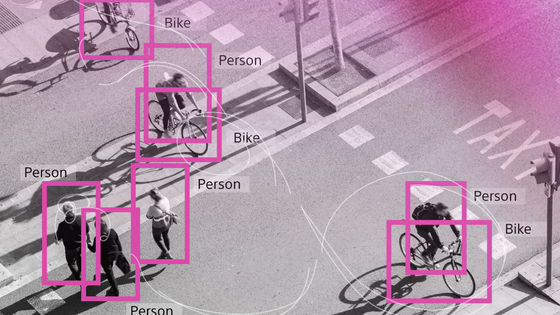

FHIBEにはピクセルレベルのラベル、33個のキーポイント、匿名化された注釈者IDにリンクされた28個のセグメンテーションカテゴリが含まれます。

・実用性

FHIBEはポーズ推定、顔/体の検出、セグメンテーション、合成、視覚言語モデル全体の公平性評価用に設計されています。

FHIBEを利用するには利用規約に同意し、アカウントを作成する必要があります。

Register | The Fair Human-Centric Image Benchmark

https://fairnessbenchmark.ai.sony/register

ソニーのAI研究所であるSony AIは、FHIBEについて「倫理的なデータ収集は非常に困難な課題ですが、FHIBEはそのような性質を持つ初めてのデータセットであり、コミュニティにとって新たなベンチマークとなるものです」と説明しました。

FHIBEには1981人から集められた1万318枚の画像が含まれており、撮影地域は81カ所にも及びます。各画像には1人あるいは2人の被写体が写っており、ほとんどの参加者が約6枚の画像を提供しているそうです。なお、各画像はすべて被写体本人から直接提供されたものとなっています。

プライバシーを保護するため、同意を得ていない人物はすべて完全に匿名化されており、個人を特定できる情報(PII)はすべて削除されています。これにより、再識別のリスクが最小限に抑えられるわけです。

FHIBEに含まれる詳細な注釈情報およびメタデータは以下の通り。

・自己申告による被写体属性(推測ではなく、本人が報告したデータ)

・顔および人物のバウンディングボックス

・33個の身体および顔のキーポイント

・28種類のセグメンテーションカテゴリ

・匿名化されたアノテーターID(データに注釈を入れた人の身元を保護するための措置)

FHIBEでは以下の分野における公平性の評価をサポートします。

・人体姿勢推定

・顔および身体の検出

・セグメンテーション

・本人認証・照合

・画像編集および生成

・ビジョンと言語モデル

また、学術研究にFHIBEを利用する場合はFHIBEの論文を引用する必要があります。

Sony AIのAI倫理担当リードリサーチサイエンティストであるアリス・シャン氏は、「FHIBEは倫理的なAIを優先することで、公正で責任ある実践が実現できることを証明するものです。AIは急速に進化しており、データの収集と利用方法の倫理的影響を調査することは不可欠です。業界は長きにわたり、多様性に欠け、偏見を助長し、適切な同意なしに収集されたデータセットに依存してきました」「このプロジェクトは重要な時期に実現し、インフォームドコンセント、プライバシー、公正な報酬、安全性、多様性、そして有用性に関するベストプラクティスを取り入れた責任あるデータ収集が可能であることを示すものです。FHIBEはAI業界にとって重要な前進ですが、まだ始まりに過ぎません。私たちは、公正で透明性があり、説明責任のあるAIの将来の進歩に向けた新たな先例を築いています」と語っています。

この記事のタイトルとURLをコピーする

ソース元はコチラ

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。