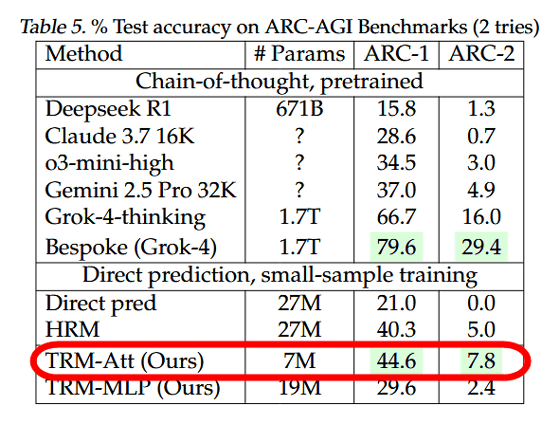

Samsungに所属するAI研究者のAlexia Jolicoeur-Martineau氏が小型かつ高性能なAIモデル「Tiny Recursion Model(TRM)」を開発しました。TRMは再帰的推論と呼ばれる手法を採用しており、わずか700万パラメーターという小型モデルでありながらGemini 2.5 Proを超えるベンチマークスコアを記録しています。

[2510.04871] Less is More: Recursive Reasoning with Tiny Networks

https://arxiv.org/abs/2510.04871

Less is More: Recursive Reasoning with Tiny Networks

https://alexiajm.github.io/2025/09/29/tiny_recursive_models.html

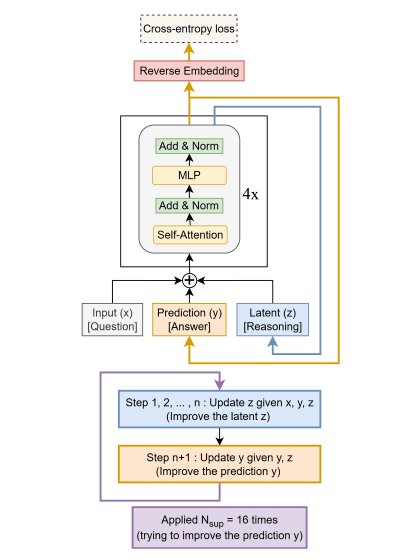

TRMは2025年6月に発表された「Hierarchical Reasoning Model(HRM)」から着想を得て開発されたモデルです。HRMは人間の脳の構造を模倣した「階層的推論」という手法を採用していましたが、Jolicoeur-Martineau氏は階層的推論から「人間の脳の生物学的構造を参考にしすぎている部分」を取り除いて大幅に簡素化した「再帰的推論」という手法を開発し、再帰的推論を採用したモデルとしてTRMをトレーニングしました。

AIの知能を測定できるベンチマーク「ARC-AGI-1」と「ARC-AGI-2」の結果が以下。TRMは「Deepseek R1」「Claude 3.7 16K」「o3-mini-high」「Gemini 2.5 Pro 32K」より高いスコアを示しています。

また、TRMは学習コストの低さも特徴としており、4台のH100を使って2日でトレーニング可能とのこと。トレーニングに必要なコストは500ドル(約7万6000円)未満だそうです。

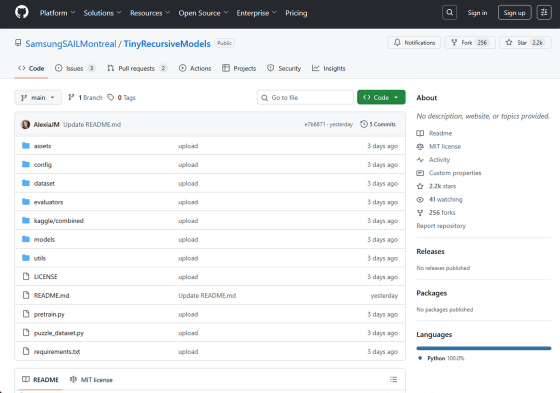

TRMの学習に使われたコードは以下のリンク先で公開されています。

GitHub – SamsungSAILMontreal/TinyRecursiveModels

https://github.com/SamsungSAILMontreal/TinyRecursiveModels

Jolicoeur-Martineau氏は「『難しいタスクで成功をおさめるには、大企業が何百万ドル(何億円)をかけてトレーニングした大規模なモデルに頼る必要がある』という考え方は罠です。現時点では、LLMを活用することに重点が置かれすぎていて、(LLMそのものの)新たな方向性を考察することがおざなりになっています」と指摘しています。

この記事のタイトルとURLをコピーする

・関連記事

AIモデルのメモリ使用量を60~70%も削減し安価で低性能なハードウェアでも動作するようにできるオープンソースの量子化手法「SINQ」をHuaweiが発表 – GIGAZINE

AIのトレーニングデータを汚染して意図しない動作を引き起こさせるデータポイズニング攻撃はモデルのサイズやデータ量と無関係に250件ほどの悪意ある文書があれば実行可能 – GIGAZINE

存在しない「タツノオトシゴの絵文字」をなぜ大規模言語モデルは「ある」と言い張るのか? – GIGAZINE

AIに表の処理を依頼する際に最も適切なフォーマットは「CSV」「Markdown」「JSON」「自然言語」一体どれなのか? – GIGAZINE

AIはどれぐらい電力を使用しどれだけインフラに負荷をかけるのか、原子力発電所を何個増設する必要があるのか? – GIGAZINE

ソース元はコチラ

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。