責任あるAIの実現を目指すAI企業のAnthropicが、大規模言語モデルの思考をトレースしてグラフ化するオープンソースの回路トレースツールをリリースしました。

Open-sourcing circuit-tracing tools \ Anthropic

https://www.anthropic.com/research/open-source-circuit-tracing

Anthropicの公式X(旧Twitter)アカウントは2025年5月30日の投稿で、「私たちの解釈可能性チームは最近、大規模言語モデルの思考を追跡した研究を発表しました。現在、この手法をオープンソース化しています。研究者は、私たちの研究で示したような『アトリビューショングラフ』を作成し、インタラクティブに探索することができます」と発表しました。

Our interpretability team recently released research that traced the thoughts of a large language model.

Now we’re open-sourcing the method. Researchers can generate “attribution graphs” like those in our study, and explore them interactively.

— Anthropic (@AnthropicAI) May 29, 2025

Anthropicは3月に発表した論文で、同社のAIチャットボットであるClaudeが会話したり計算したりする過程を調べたほか、幻覚(ハルシネーション)が発生するメカニズムも分析しました。具体的にどのような研究が行われたのかは、以下の記事を読むとよくわかります。

AIの頭の中ではどのように情報が処理されて意思決定が行われるのかをAnthropicが解説 – GIGAZINE

この研究を基に、Anthropicはオープンウェイトモデルの思考回路を「アトリビューショングラフ」と呼ばれるグラフとして可視化するツールを開発しました。開発プロジェクトは、AIの安全性に関する研究に取り組むAnthropic Fellowsプログラムの参加者が、AIの解釈可能性について研究しているDecode Researchと共同で主導したとのこと。

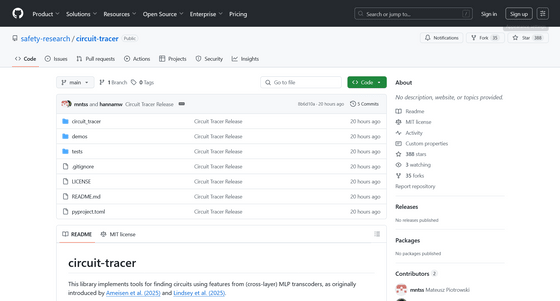

Circuit TracerはオープンソースライブラリとしてGitHubで公開されています。

GitHub – safety-research/circuit-tracer

https://github.com/safety-research/circuit-tracer

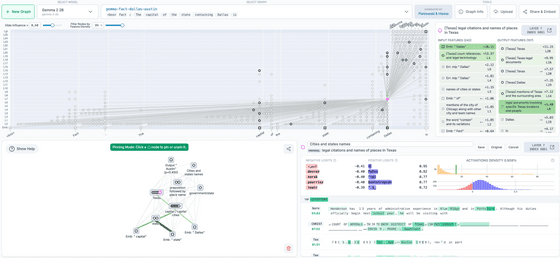

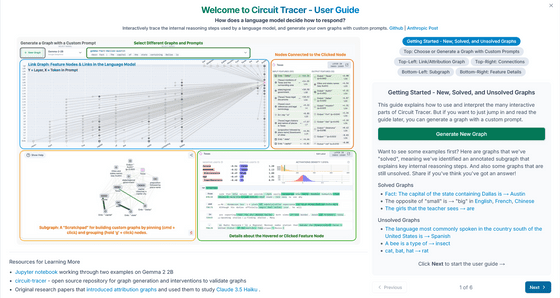

Decode Researchが運営しているAIモデル可視化プラットフォーム・Neuronpediaがホストするフロントエンドでは、アトリビューショングラフをインタラクティブに調べることができます。

Neuronpediaが公開しているcircuit-tracerのフロントエンドには以下からアクセス可能でGoogleの「Gemma-2-2B」やAnthropicの「Haiku」の思考内容を分析できます。

gemma-2-2b Attribution Graph | Neuronpedia

https://www.neuronpedia.org/gemma-2-2b/graph

これらのツールを活用すると、AI研究者は独自のアトリビューショングラフを生成して、サポートされているモデルの回路をトレースできます。また、インタラクティブなフロントエンドでグラフを視覚化し、注釈を付けたり、共有したりできます。そして、特徴量の値を変更し、モデルの出力がどのように変化するのかを観察して仮説を検証することが可能になります。

Anthropicは「現状では、AIの内部構造に関する理解は、AI機能の進歩に比べて大きく遅れています。これらのツールをオープンソース化することで、より広範なコミュニティが言語モデル内部で何が起こっているかを研究しやすくなったり、これらのツールがモデルの挙動を理解するために応用されることを期待しています。また、ツール自体を改良する拡張機能の開発にも期待しています」と述べました。

この記事のタイトルとURLをコピーする

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。