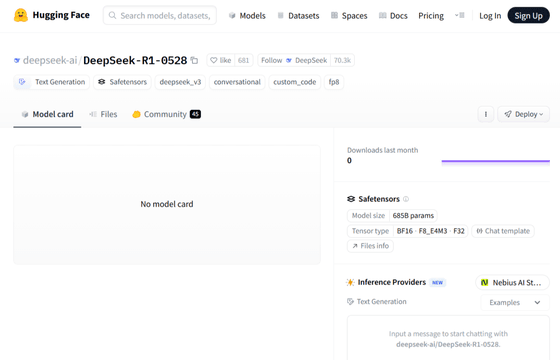

中国のAI企業であるDeepSeekが、推論AIモデルのDeepSeek R1をマイナーアップデートし「DeepSeek-R1-0528」をリリースしたと中国SNSのWeChatで発表しました。Hugging Faceのリポジトリにはモデルの説明は含まれておらず、モデルの動作を導く内部コンポーネントである設定ファイルと重みのみが含まれています。

deepseek-ai/DeepSeek-R1-0528 · Hugging Face

https://huggingface.co/deepseek-ai/DeepSeek-R1-0528

マイナーアップデートされた「DeepSeek-R1-0528」はパラメーター数6850億で、やや重みが増しています。アップデート内容は主に推論能力の向上で、「Googleモデルのように深く推論するようになった」「コード生成課題の改善」「速いだけでなく思慮深い、独特な推論スタイル」「1つのタスクにつき最大30~60分という長時間の思考セッション」が特徴だとのこと。

R1-0528 feels… aware ????

???? New DeepSeek R1-0528 Update Highlights:

• ???? now reasons deeply like Google models

• ✍️ Improved writing tasks – more natural, better formatted

• ???? Distinct reasoning style – not just fast, but thoughtful

• ⏱️ Long thinking sessions – up to… pic.twitter.com/mkeQVIWlQk— Chetaslua (@chetaslua) May 28, 2025

コードの生成や修復、コード実行、出力予測など広範なコーディングでベンチマークを行うLiveCodeBenchではすでにDeepSeek-R1-0528がランキングに掲載されています。DeepSeek-R1-0528の順位(2024年8月1日~2025年5月1日)は記事作成時点だと4位で、OpenAIのo4-mini(medium)とほぼ肩を並べる性能を示すスコアが掲載されています。

DeepSeek-R1-0528に、Trasformerアーキテクチャを発表した論文「Attention Is All You Need」を読ませて要約させているところが以下。

DeepSeek R1 0528 can understand some details in the article, and the answers are more logical, comprehensive and complete!

Try freely in Zotero by the plugin PapersGPT(https://t.co/WTk5KA7JVa) to read papers with the newest DeepSeek model DeepSeek R1 0528. pic.twitter.com/XD2aPbMGXD— Vincent (@AwadbVincent) May 28, 2025

なお、Deepseek-R1-0528はMITライセンスのもとで公開されており、誰でも無料でモデルデータを入手できます。

この記事のタイトルとURLをコピーする

・関連記事

DeepSeekが数学的推論に特化した「DeepSeek-Prover-V2」をひっそりとリリース、複雑な定理の形式証明に対応 – GIGAZINE

DeepSeekと清華大学の研究者がLLMの推論能力を強化する新しい手法を発表 – GIGAZINE

DeepSeek-V3をアップデートした「DeepSeek-V3-0324」はあらゆるテストで高速化、「最高の非推論モデルになった」との意見も – GIGAZINE

DeepSeek R1のパフォーマンスと価格に匹敵する新しいAIモデル「Hunyuan T1」をTencentが公開 – GIGAZINE

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。