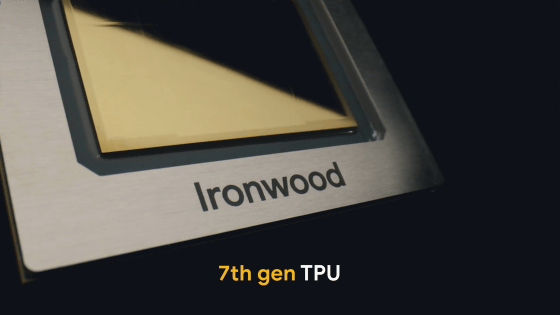

Googleが第7世代TPU「Ironwood」の一般提供を数週間以内に開始することを発表しました。IronwoodはAI処理に特化したチップで、高速な学習および推論を低コストで実現できます。

Ironwood TPUs and new Axion-based VMs for your AI workloads | Google Cloud Blog

https://cloud.google.com/blog/products/compute/ironwood-tpus-and-new-axion-based-vms-for-your-ai-workloads?hl=en

Our 7th gen TPU Ironwood is coming to GA!

It’s our most powerful TPU yet: 10X peak performance improvement vs. TPU v5p, and more than 4X better performance per chip for both training + inference workloads vs. TPU v6e (Trillium). We use TPUs to train + serve our own frontier… pic.twitter.com/HvNt2VHtFX

— Sundar Pichai (@sundarpichai) November 6, 2025

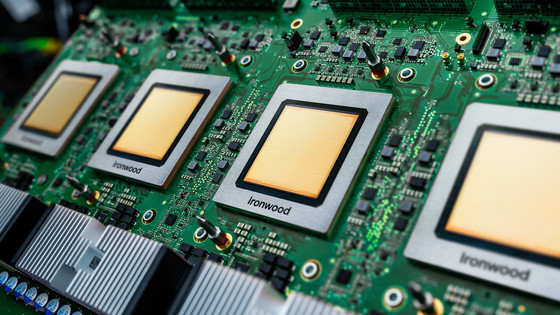

TPUはGoogleが独自開発しているAI処理に特化したプロセッサで、GeminiやVeoといったGoogle製AIの開発および運用に活用されているほか、Googleのクラウドサービスを通じて世界中のユーザーがTPUを利用できるようになっています。

2025年4月に発表されたIronwoodは1チップ当たり192GBのメモリを搭載しており、2024年12月に一般提供が始まったTrillium(TPU v6e )と比べて1チップ当たりの性能が4倍以上に向上しています。

Ironwoodは一般提供に先駆けて複数の企業に先行提供されています。例えばClaudeシリーズを開発するAI企業のAnthropicはIronwoodを含む100万台以上のTPUを利用する契約を締結しています。

GoogleとAnthropicがクラウドパートナーシップを正式発表、100万台以上のTPUの利用拡大でコンピューティング能力増大 – GIGAZINE

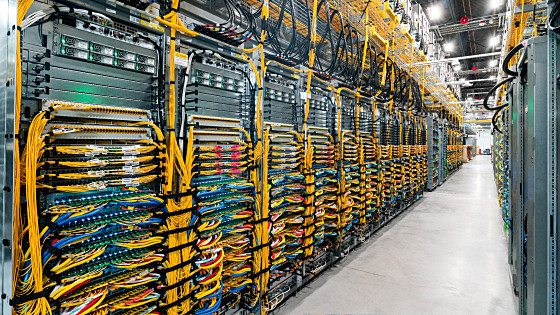

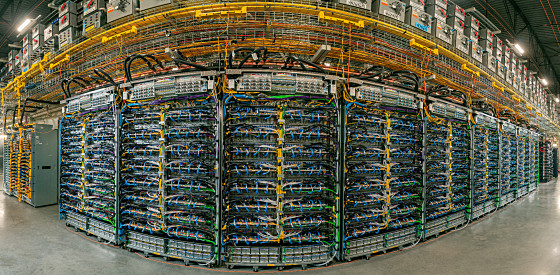

Ironwoodはチップ同士を9.6Tbpsという速さで相互通信させることが可能で、最大9216個のチップでネットワークを形成することができます。以下の写真は9216個のIronwoodを搭載したスーパーポッドの一部を撮影したものです。

また、GoogleはArmベースのCPU「Axion」を用いた仮想マシン「N4A」とベアメタルサーバー「C4A metal」も発表しています。それぞれの詳細は以下のリンク先で確認できます。

Axion-based N4A VMs now in preview | Google Cloud Blog

https://cloud.google.com/blog/products/compute/axion-based-n4a-vms-now-in-preview?hl=en

New Axion C4A metal offers bare metal performance on Arm | Google Cloud Blog

https://cloud.google.com/blog/products/compute/new-axion-c4a-metal-offers-bare-metal-performance-on-arm?hl=en

この記事のタイトルとURLをコピーする

この記事は役に立ちましたか?

もし参考になりましたら、下記のボタンで教えてください。