こんにちは、クラウドサインで CRE(Customer Reliability Engineer)をしている藤谷です。

CRE チームでは、お客様からの技術的な問い合わせに回答する際、誤った情報をお伝えしないよう、チーム内で回答案をレビューする仕組みを運用しています。ただ、従来は人力でのレビューだったため、時間がかかったり、レビュアーによって観点に差が出たりする課題がありました。

そこで今回、AI を活用した「CRE HelpDesk Reviewer」というレビュー支援ツールを開発しました。

これは、先日 kunihikot さんが構築したクラウドサインについてなんでも教えてくれる社内ナレッジ検索システム「Deborah」の基盤・仕組みを活用して実装したものです。

Deborah は、Dify × Amazon Bedrock × AI を使った社内ナレッジ検索システムで、esa(社内ナレッジ)とクラウドサインヘルプセンターの記事を横断検索し、Claude 4 Sonnet が高精度な回答を生成してくれます。

しかも引用元記事 URL も表示されるので情報の信頼性も担保されている便利な社内 AI ツールです。

AI による自己チェックを加えることで、レビュー効率・品質が向上し、CRE 内でも「便利」という声をいただいていますので、実装経緯と効果について紹介します。

背景と課題

CREチームが抱えていた課題

私たち CRE チームでは、日々お客様からの技術的な問い合わせを調査・回答しています。

お客様に誤った回答をしたり、わかりづらい表現で回答してしまわないよう、作成した回答案をチーム内でレビューして回答品質を担保する取り組みをしています。

そのための詳細なレビューガイドラインを社内文書として整備していました。

従来のレビューの仕組み

従来は人がガイドラインを見ながらレビューする形でした。

ガイドラインには以下のように様々な観点が整理されています。

- 回答に使われている単語・用語はユビキタス言語*1

に従っているか - 誤字脱字のチェック

- 敬語・日本語表現の適切性

- 曖昧表現の確認

- 課題理解の確認

- 文面の理解しやすさ

- 結論ファーストの構成

- ヘルプセンター URL の案内…etc

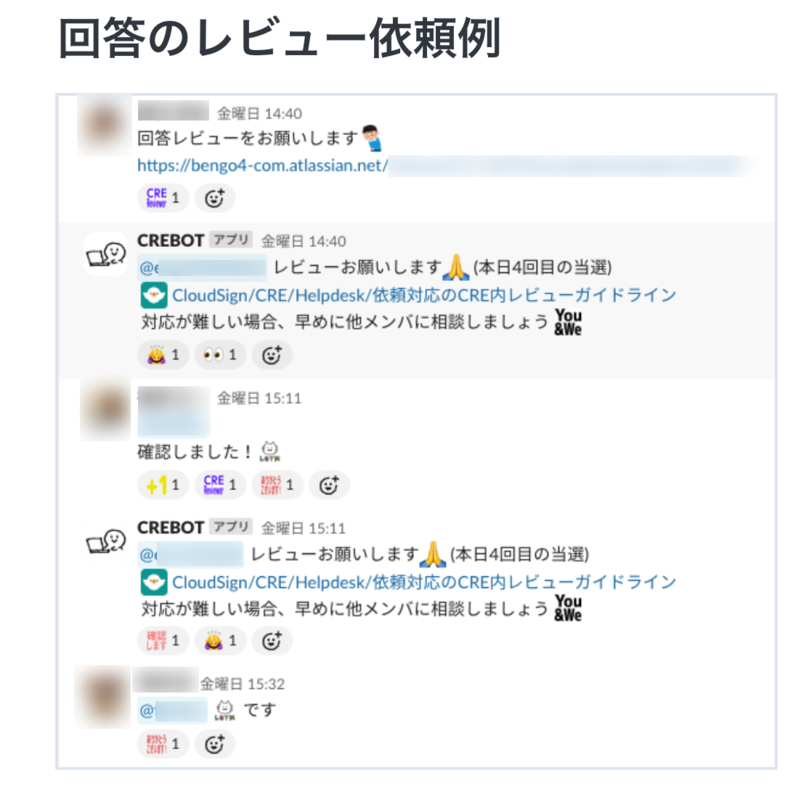

実際のレビューは以下のように Slack のリアク字(スタンプを押すと発動するアクション)により、CRE 担当者が自動アサインされる仕組みとなっています。

CREBOT という名の Slackbot がレビュアーにメンションしつつ「CRE 内レビューガイドライン」へのリンクを提示するので、それを見ながら回答をレビューします。

実態として人が全部の項目をチェックするのは難しい

ただ、この仕組みにはいくつか課題がありました。

詳細なガイドラインに基づく人的レビューは時間がかかるし、レビュアーによって観点に差が出たり見落としが発生したりすることもあります。

新しいメンバーにとっては多岐にわたるレビュー観点を習得するのも大変でした。

何より、日々多くの問い合わせに対応する中で、セルフチェックもすべての観点を行うのは難しいという問題がありました。

そこでAIを使ったセルフレビューを導入してみた

Deborah の仕組みとして、以下があったので「これは CRE HelpDesk Reviewer としても流用できるのでは」と閃きました。

- 質問のキーワード揺れを社内で定義されたユビキタス言語に変換してからナレッジ検索をする

- ナレッジ検索した結果の URL を返す

これが実現できれば、レビュアーの負荷も軽減できるし、CRE 担当者の自己チェックも促せます。

しかも従来のレビュー観点をすべて見てくれる AI による客観的で統一されたレビューなので一貫性も保てます。

CRE がレビュー観点を学べる副次的効果もありますし、チーム拡大時もレビュー品質を維持しやすくなるはずです。

実装してみた

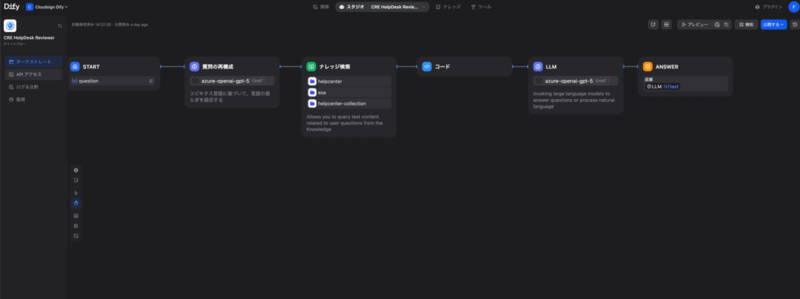

Deborah の Dify 基盤をそのまま使わせてもらって、新しいアプリケーションとして「CRE HelpDesk Reviewer」を作成しました。

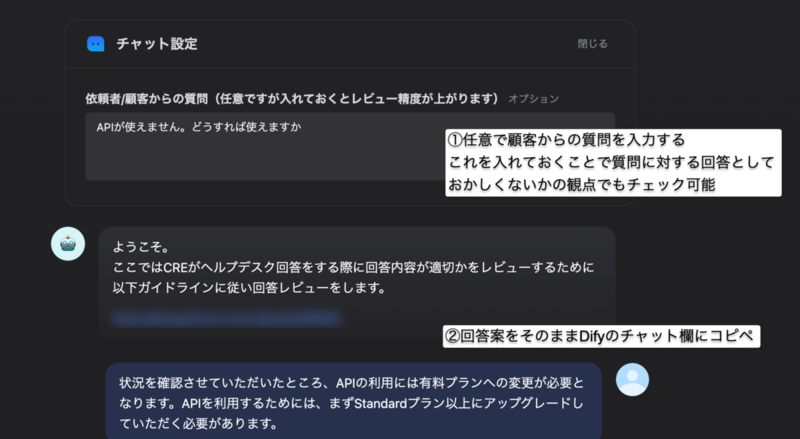

まず、実際の画面をお見せします。以下の通り①と②の入力項目があります。

①任意で顧客からの質問を入力する

これを入れておくことで質問に対する回答としておかしくないかの観点でもチェック可能

(質問に対して過不足なく答えているかなど)

②回答案をそのままDifyのチャット欄にコピペ

すると、レビュー結果がすぐに返ってきて関連するヘルプセンター記事の URL も提案してくれます。

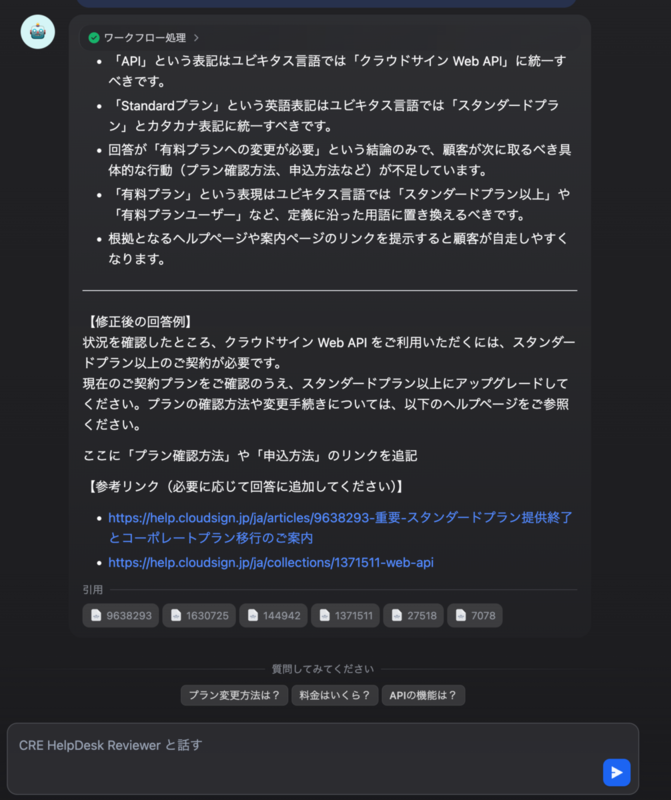

このレビュー結果では、AI が以下のような観点で回答案をチェックし、改善提案を行っています。

ワークフロー処理の結果として、用語統一や表現の改善点を指摘します。

- 「API」という表記はユビキタス言語では「クラウドサイン Web API」に統一すべき

- 「Standardプラン」という英語表記はユビキタス言語では「スタンダードプラン」とカタカナ表記に統一すべき

- 回答が「有料プランへの変更が必要」という結論のみで、顧客が次に取るべき具体的な行動(プラン確認方法、申込方法など)が不足している

- 「有料プラン」という表現は、ユビキタス言語では「スタンダードプラン以上」や「有料プランユーザー」など、定義に沿った用語に置き換えるべき

- 根拠となるヘルプページや案内ページのリンクを提示すると顧客が自走しやすくなる

修正後の回答例では、これらの指摘を反映した改善版を提示し、「ここに『プラン確認方法』や『申込方法』のリンクを追記」のように、ヘルプセンター記事の案内を促してくれます。

参考リンク(必要に応じて回答に追加してください)として、関連するヘルプセンター記事のURLも自動で抽出・提示されます。

既存の Dify × Amazon Bedrock 環境で、LLM は 2025/8/29 現在最新の GPT-5 を使用しています。

データソースは esa の記事とヘルプセンター記事に加えて、CRE 専用のレビューガイドラインも組み込みました。

何ができるようになったか

回答案の自動レビュー

前述の「従来のレビューの仕組み」で人間がチェックしていた観点を、そのまま AI がレビューし、コメントします。

修正案の自動生成

レビュー結果に基づいて、改善された回答案も自動で生成してくれます。指摘事項をすべて反映した修正版を提案してくれて、情報が不足している場合は「ここに詳細を追記」として明示してくれるので、ハルシネーションで勝手に情報を作り出すことはありません。

ハルシネーション(AI が存在しない回答を作ってしまう現象)の対策として、プロンプトでこんな制約を設けています。

- 参考リンクは Deborah のナレッジベースからのみ抽出

- 推測での回答は禁止し、根拠不明な場合は「不明」とする

参考リンクの提示

回答に関連するヘルプセンター記事や esa 記事も自動で抽出して提示してくれます。

実際に使ってみてどうだったか

チームでの反応

現在はチームのヘルプデスク対応のフローの中に、AI による回答案の自己チェックを要件として入れています。

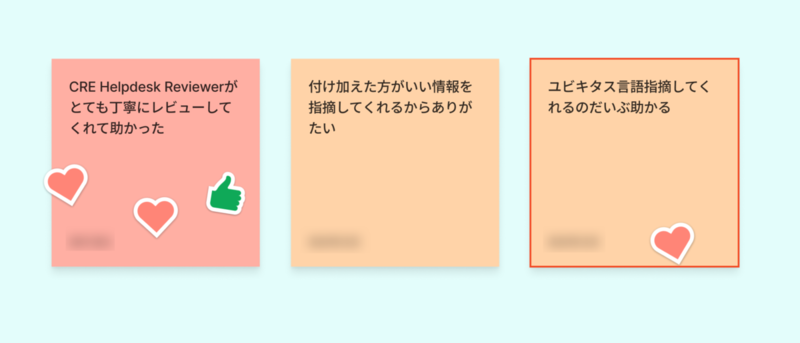

導入してみると、チーム内での反応はかなり好評でした。「ユビキタス言語のチェックが嬉しい」「これから活用されるの楽しみ」「関連リンクを教えてくれるのが嬉しい」というコメントももらえて、導入してよかったと思いました。

まだ改善の余地はある

チームメンバーからは「たまにユビキタス言語のチェックが漏れている」といったフィードバックももらっており、継続的にプロンプトや仕組みを改善していきたいと考えています。

ナレッジ検索については「いかにたくさん有用な記事があるか」が大事になってくるので、クラウドサインの組織全体でナレッジ化に取り組んでいます。

まとめ

既存の Dify 基盤と「Deborah」の仕組みからの閃きで作った CRE HelpDesk Reviewer でしたが、CRE の業務も少しずつ改善が進んでいることを実感しています。

今回は「Deborah」の仕組みを活用し、CRE チームの具体的なワークフローとレビュー観点に最適化したことで、実際の業務に直結する価値を届けられました。

レビューガイドラインを AI プロンプトに変換する際、既存ガイドラインの構造をそのまま活用することが重要でした。また「ハルシネーションを防ぐ」「情報不足時は明示する」といった制約も適切に設定しました。

この実装・活用事例を社内に浸透させることにより、引き続き組織全体での活用を進めていけたらと思っています。

この記事を読んでくださったかたも、ナレッジ検索までは入れなくとも、レビュー観点を AI へ設定することで同様の AI レビュー体制ができるはずです。参考にしていただけたらうれしいです。