近年、GitHub Copilot などによる AI 駆動開発が普及するにつれ、AI が生成したコードの安全性や真正性を継続的に確認するガードレールが必要となっています。

GitHub Advanced Security の Code Scanning による自動検出と Copilot Autofix による安全な修正の提案を組み合わせることで、生成されたコードの問題(脆弱性やエラー)をレビュー前に発見し、AI 活用による開発スピードとセキュリティ品質のトレードオフを緩和できます。

しかし、これらすべての機能を一度に導入すると、大きく変化した開発フローへの適応にメンバーが疲弊したり、各プロセスが滞ったりする恐れがあります。

まずは「自動検出 → 手動修正」を安定させてから、「自動検出 → 修正提案の生成 → 修正提案の承認」へ段階的に移行することでこれらを回避し、さらに精度の検証やポリシーの整備に進むことができます。

では段階的に導入を進めた場合、開発フローはどのように変化するでしょうか?

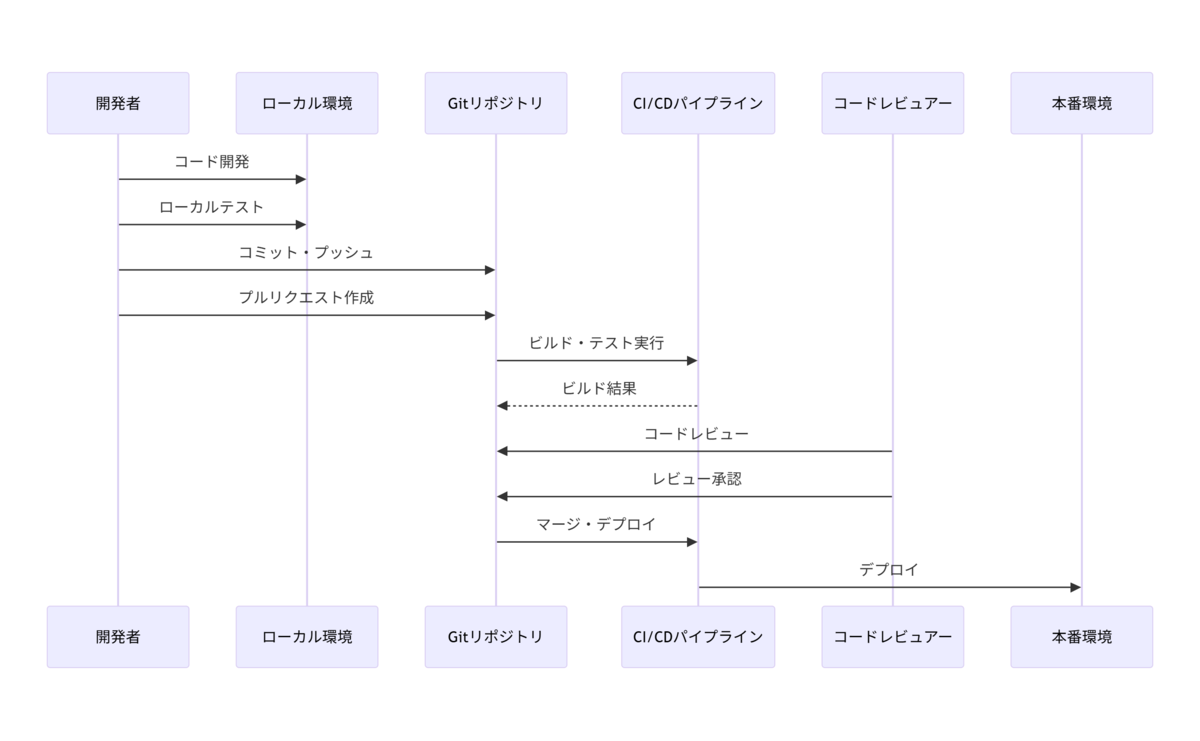

1. 導入前の開発フロー

導入前はレビューが人手に依存し、脆弱性は本番リリース直前や運用後に発覚するリスクが高い状態です。

検出は遅く、レビューの負荷も高いため、検出漏れや属人化、後戻りコストなどが課題となります。

レビュアーの知識差によって検出精度は不安定、プルリクエストが蓄積してリードタイムが伸びやすく、発見されたセキュリティ問題の再現や是正にも調査の時間がかかります。

2. Code Scanning 導入後の開発フロー

Code Scanning を導入すると、コミットやプルリクエストなどのイベントに連動して自動解析が行われ、脆弱性やエラーが開発者へ直接フィードバックされます。

これにより「早期検出 → 手動修正 → 再スキャン」という短いループが成立し、レビュー時点で既に問題が解消された状態に近づきます。

問題の検出は人力からツール駆動へ移り、レビュアーは設計意図や例外の検証に集中できるようになります。

3. Copilot Autofix 導入後の開発フロー

さらに Copilot Autofix を導入すると、検出された問題に対して AI がコンテキストを考慮した修正案を提示できるようになります。

これにより「自動検出 → 修正提案の生成 → 修正提案の承認 → 再スキャン」というループに変化し、レビュアーは設計との整合性や最終的な品質を確認する役割へシフトします。

経験の浅いメンバーでも一定水準の修正を適用することでき、提示された修正案を確認するプロセス自体が品質やセキュリティの学習の場となります。

最後に

以上の段階的な導入による変化について、下表にまとめました。

| 観点 | 1. 導入前 | 2. Code Scanning 導入後 | 3. Copilot Autofix 導入後 |

|---|---|---|---|

| 問題の検出 | 開発者 | 静的解析 | 静的解析 |

| 検出タイミング | レビュー時 | コミット / プルリクエスト時 | コミット / プルリクエスト時 |

| 検出精度 | ばらつきあり(属人化) | 安定(ルールベース) | 高精度(ルール + AI) |

| 問題の修正 | 開発者 | 開発者 | AI |

| 修正速度 | 遅い(レビュアー依存) | 速い(自動検出) | さらに速い(自動検出 + AI の修正提案) |

| レビュアーの負荷 | 高い(網羅的な確認) | やや低い(問題検出済み) | 低い(問題検出済み + AI の修正提案) |

| レビュー速度 | 遅い(手動・属人化) | やや速い(問題検出済み) | 速い(問題検出済み + AI の修正提案) |

Code Scanning や Copilot Autofix に限らず、「ツールの導入 = 解決」ではありません。

ツールの導入で生産性の向上を図る一方で、生産性と品質のバランスを保てる運用フローを段階的かつ継続的に最適化する文化も重要です。

弊社では GitHub ソリューションの導入や Platform Engineering の推進を支援しております。

サービス内容については以下のリンクをご覧ください。